CAPIRE L’ARTIFICIAL INTELLIGENCE NON E’ PIU’ UN OPTIONAL. ECCOLA SPIEGATA (dal blog di Paolo Barnard qui)

Nell’educazione politica dei cittadini va oggi inserita come prioritaria la comprensione dell’Artificial Intelligence (di seguito AI).

Così come cinquant’anni fa l’arrivo del personal computer ha cambiato ogni angolo della vita privata, professionale, economica e politica, così è oggi l’AI, solo immensamente di più. Le ‘macchine pensanti’ saranno ovunque e gestiranno quasi tutto, punto. Ma su cosa davvero sia l’AI, e cosa sarà, c’è un’enorme confusione, soprattutto a causa delle fantasie cinematografiche e dell’iperbole nei media. L’AI va quindi capita con lucidità. Ma attenti: date le sue straripanti applicazioni nella politica, economia, istruzione, lavoro e salute, oggi non saperlo non è più un optional.

Dovete iniziare da questa domanda: gli umani già posseggono l’intelligenza, frutto di un improvviso e ancora misterioso salto genetico avvenuto fra 200 e 100 mila anni fa in un ramo di primati; allora perché oggi stiamo ossessivamente cercando di crearne un’altra, quella artificiale?

Esiste solo una risposta: perché quella artificiale dovrà essere molto più potente di quella umana. Infatti non avrebbe senso investire miliardi e lavorare decenni per riottenere delle capacità artificiali pari a quelle naturali dell’uomo. Ma qui ho appena usato un termine che è la chiave di tutta la comprensione della vera AI: “capacità”. Infatti l’attuale AI non ha assolutamente nulla di intelligente, cioè nulla di neppure lontanamente comparabile alle funzioni cognitive del cervello umano; essa ha unicamente delle capacità computazionali prodigiose che gli derivano da istruzioni sempre più sofisticate. Fra capacità artificiali e intelligenza naturale esiste un divario di dimensioni colossali. L’aver usato Intelligence nella locuzione Artificial Intelligence ha portato a un’incomprensione enorme in tutto il mondo, e infatti la locuzione più idonea sarebbe stata Capacità Artificiale, non intelligenza artificiale.

Da più parti, in tema di AI, giungono apocalittici avvisi e scenari che ipotizzano un mondo da incubo dove super macchine capaci di pensieri e sentimenti propri potrebbero schiavizzare la razza umana e dunque conquistare il potere. O peggio: impossessarsi delle atomiche ed estinguerci. Queste sono sciocchezze, che appunto spariscono quando si ha chiara la sopraccitata differenza fra capacità artificiali e intelligenza naturale. Quest’ultima, che appartiene unicamente a noi, è, e quasi certamente rimarrà, irraggiungibile dalle macchine, ed è bene subito chiarirvi il motivo. Purtroppo mi devo soffermare parecchio su questo punto perché se rimaniamo distratti dall’AI fantasy dei film, finiamo per non capire niente del colossale impatto che questa tecnologia davvero avrà sulla politica, l’economia, l’istruzione, il lavoro e la salute degli umani.

SCORDATEVI C-3PO E TERMINATOR.

Prima cosa sia chiara un’altra distinzione: non esiste solo la AI, ma anche la AGI, che è la Artificial General Intelligence. La prima si riferisce a macchine che sotto la totale istruzione e direzione dell’uomo svolgono compiti estremamente complessi, come: tradurre le lingue all’istante; trovare segni patologici invisibili ai medici negli esami clinici; predire i Mercati nelle variabili indecifrabili ai traders; riconoscere miliardi di volti e collegarli senza errore ai conti correnti o ai file di Polizia; interpretare e catalogare migliaia di miliardi di dati in frazioni di secondo per uso e consumo umano, ecc. Quindi si badi bene: stiamo parlando sempre di capacità eccezionali, e non d’intelligenza cognitiva tipica dell’umano. La seconda, l’AGI, è invece il sogno dei tecnologi: le stesse macchine, con le stesse capacità, ma dotate di totale autonomia sia nell’imparare per conto proprio che nel ‘pensare’ per conto proprio alle soluzioni. Cioè che non richiedano più nessuna istruzione e direzione dell’uomo. Di nuovo però, si badi bene: parliamo in questo caso di un passo oltre, ma sempre di tecnologie e nulla a che vedere con l’esatta riproduzione di un cervello umano. Quindi neppure l’AGI rappresenta davvero le futuristiche, anche se emozionanti, fantasie alla Star Wars, Blade Runner e filone successivo.

Che replicare esattamente un encefalo umano dentro un’AGI, cioè creare la cosiddetta Superintelligence, fosse un’impresa pressoché irraggiungibile fu la chiara intuizione del padre dei computers, Alan Turing, il genio matematico inglese scomparso nel 1954. Turing lasciò ai posteri una sfida in questo senso, contenuta nel celeberrimo Turing Test che includeva anche una versione aggiornata col nome di Imitaton Game: in questi test si sarebbe misurato se mai un computer avrebbe ingannato la mente umana mostrando intelligenza superiore (e qui si parla d’intelligenza complessiva, non di abilità agli scacchi o a Go). Fu un primo tentativo di far comprendere quanto lunga in realtà fosse la strada prima di poter davvero decretare che una macchina sa pensare come un uomo, ammesso che quella strada esista in assoluto. Alan Turing lasciò infatti una predizione pessimistica in questo senso, nelle seguenti lapidarie parole: “La questione se le macchine possono pensare è talmente insignificante da neppure meritare una discussione”. I fatti gli stanno dando pienamente ragione a 60 anni di distanza e dopo salti tecnologici giganteschi: la Superintelligence non solo non c’è, ma si allontana sempre di più.

Considerate le seguenti cose, solo quattro punti per far capire, perché davvero dobbiamo sterilizzare il campo dalle fantasie degli esaltati sulla AI, pena il perdere uno dei più importanti treni politici ed economici della Storia, che è la vera AI:

- A) Nella Image Recognition, una branca della AI, ancora oggi per ottenere da una macchina ciò che il nostro cervello fa in una frazione di secondo occorrono sforzi tech immensi. Immaginate un numero 9 scribacchiato male: l’occhio e cervello umani dopo pochi istanti, senza alcuno sforzo, sanno capire se si tratta davvero di un 9 o di una g, o di disegni infantili di un girino o di un palloncino attaccato al filo, ecc. Per far sì che un computer arrivi a questo misero risultato, il lavoro di software e di artificial neural networking che gli va insegnato è estenuante. Da qui immaginate cose come la contemplazione di un affresco, e la miriade di stimoli che un cervello umano ne riceve, che vengono capiti all’istante, e che sa poi riprodurre in ogni campo cognitivo in pochi secondi per, infine, produrre azioni di ogni sorta; e di nuovo immaginate cosa ci vorrà per attrezzare un computer ad avere quelle stesse capacità se un 9 scribacchiato male richiede oggi sforzi di decine di ricercatori per farglielo azzeccare.

- B) Si fa un gran parlare in AI degli Artificial Neural Networks, cioè imitazioni delle strutture neuronali del nostro cervello messe dentro i computers per renderli più ‘intelligenti’. Sono tecnicamente fondamentali, ma anche qui la realtà è disarmante. Il cervello umano ha 85 miliardi di neuroni interconnessi, e nessuno al mondo oggi sa davvero come funziona neppure un singolo neurone. Alla New York University il luminare delle neuroscienze Rodolfo Llinas ha tentato per anni di capire come agisce il mega neurone del calamaro gigante, cioè come fa ad esempio a fagli distinguere un capodoglio da una roccia, ma è ancora… in alto mare. Perciò quando nella fantasia popolare si parla di AI o di Artificial Neural Networks come se fossimo a un passo dal trovare cervelli umani artificiali perfettamente riprodotti che ci faranno psicoterapia in un ‘Apple consultorio’, o che svolgeranno indagini di polizia, si parla di stupidaggini.

- C) Un altro trofeo del nuovo mondo in AI sono i sistemi di navigazione che tutti usiamo in auto e quelli ancor più sofisticati in arrivo per il futuro Driverless di auto, camion, aerei, drones ecc. Cose strabilianti senza dubbio, ma se si parla di esse come fosse intelligenza si va sul ridicolo. Il cervello umano racchiude in pochi cm quadrati delle capacità computazionali simultanee nella gestione dello spazio-tempo e nella sua valutazione cognitiva che nessun computer neppure lontanamente oggi sa riprodurre. Le api hanno appena 800.000 neuroni in un cervello grande come la capocchia di uno spillo, ma posseggono sistemi di navigazione talmente sofisticati che, per riprodurli, a noi occorrono computer giganteschi con l’appoggio di enormi strutture sia terrestri che nello spazio. Anche questo vi dà il senso della distanza fra macchine ‘intelligenti’ e natura davvero intelligente.

- D) Hanno fatto molta impressione sul pubblico le notizie delle prodezze di AI come Deep Blue e AlphaGo, cioè dei set d’istruzioni ‘pensanti’ dentro una macchina che hanno sconfitto giocatori-geni umani. Da lì molti hanno immaginato che eravamo a un passo dalla AGI detta Superintelligence, ma assolutamente no. Ciò che non viene fatto capire al pubblico è l’infinita differenza che c’è fra un cervello che impara senza alcuna istruzione su come imparare (l’umano), e un cervello che invece prima di imparare deve essere fornito da un esterno delle istruzioni su come imparare (la AI). Per essere chiari: un infante di 2 anni apprende un codice immensamente complesso come quello del linguaggio e dei suoi contenuti di coscienza senza che nessuno gli infili nel cranio un software su come apprendere linguaggio e coscienza. Invece un’AI prima di imparare il linguaggio e i suoi contenuti dovrà sempre dipendere dall’intelligenza umana che gli sappia ficcare dentro istruzioni sempre più complesse su come E’ vero che si parla di macchine avanzatissime che oggi apprendono alcune cose da sé, tuttavia all’inizio della catena c’è d’obbligo la discrezionalità delle istruzioni umane su come apprendere, cosa che nella biologia umana non accade, noi nasciamo già completi. Ma soprattutto un altro punto.

Come faranno gli scienziati ad arrivare a riprodurre in una macchina i meandri dell’intelligenza se neppure ancora sanno minimamente come questi funzionino in un encefalo biologico? Davvero la Agi con Superintelligence sono ancora fantasie.

E quindi non è un caso che dopo 60 anni dal genio di Alan Turing arrivi proprio oggi una botta di mesto realismo sulla testa della cosiddetta AI Community. Si parla sempre più fra i top esperti di un ‘inverno’ che sta calando sulla AI. Quello che è oggi considerato il Pitagora della AI, Yann LeCun, era stato assunto da Facebook come Guru supremo della loro AI nella speranza di avvicinarsi alla Superintelligence, ma oggi LeCun si sta defilando da Zuckerberg, e sta più nell’ombra.

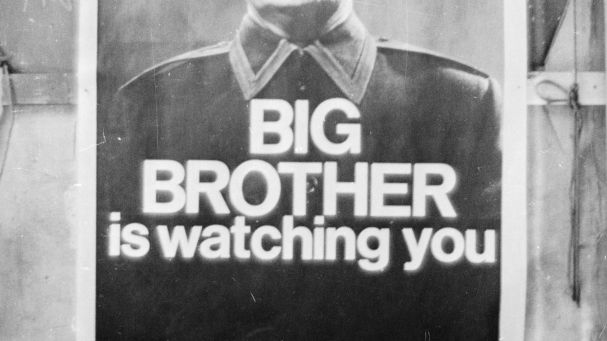

Tutto questo per dare ai lettori un quadro informato e realistico di cosa davvero s’intende oggi per Artificial Intelligence, quando tutti sparlano di AI come macchine che schiavizzeranno il mondo e di scenari futuri da Isaac Asimov. Non fatevi impressionare dal fatto che Silicon Valley di tanto in tanto riunisca i massimi cervelli in dibattiti sull’etica delle future macchine ‘intelligenti’. DeepMind, che è il centro d’eccellenza sull’AI del colosso Google-Alphabet a Londra, ha lanciato Ethics&Society come laboratorio permanente di studio sulla moralità e sui benefici umani di queste tecnologie. Ma tutto ciò non significa affatto che dietro l’angolo davvero c’è il Terminatorpronto a comparire a schermi unificati nel Pianeta per annunciare la fine dalla razza umana. La discussione sull’uso delle tecnologie e sul loro impatto sull’umanità è, come dire, un contorno che sempre viene servito col piatto principale, e questo fin dall’invenzione della dinamite. Il fatto che le supertech possano finire in networks di controllo politico e di repressione di massa, o addirittura essere usate nelle armi di sterminio della specie, è del tutto vero, ma come sempre sarà la mano dell’uomo a decretarlo, non una Superintelligence che un mattino si sveglia a pigia i bottoni (per i Nerds: tech singularity is a joke, checché ne dica Elon Musk e altri infatuati come Ray Kurzweil).

Spero che siate arrivati fin qua. Ora la parte cruciale invece, perché rimane assolutamente vero che la AI come strumento di gestione comandato dall’uomo nella vita moderna e in ogni campo conosciuto – quindi dalla politica alla Medicina, dalle comunicazioni all’industria, dai servizi alla finanza, dall’istruzione al mondo del lavoro – sia oggi la più grande rivoluzione nelle nostre vite dopo l’arrivo dei computer, ma molto più dirompente, per cui nessuno la deve ignorare, pena rimanere esclusi in una vita da analfabeti ottocenteschi.

Quindi per completare il quadro generale di cosa sia la realistica AI e di come appunto cambierà quasi tutto, vanno descritti i tre pilastri che la compongono e di cui già si sente parlare, ad esempio, nelle offerte lavorative, nella innovation aziendale, e nelle infrastrutture nazionali: MACHINE LEARNING, DEEP LEARNING e gli ARTIFICIAL NEURAL NETWORKS.

MACHINE LEARNING.

Nasce attorno ai primi anni ’80 e la grande innovazione che porta è di sostituire i codici di software scritti a mano dai programmatori con un altro tipo d’istruzioni per i computers affinché… imparino da soli. L’idea fu che se una macchina, invece di dipendere al 100% dal software umano per sapere come svolgere un compito, fosse riuscita a usare il suo enorme potere di calcolo per apprendere, migliorare il proprio giudizio e poi completare quel compito, ovviamente i risultati sarebbero stati mille volte maggiori. Quindi invece di mettere un tradizionale software nel computer (Machine), i tecnici gli permettono d’imparare (Learning) ficcandogli dentro enormi quantità di dati e di algoritmi che appunto gli permettono d’imparare da solo come svolgere quel compito. Cosa accade in pratica dentro al cervello della macchina? Accade che gli algoritmi, che sono in sé istruzioni, studiano la massa dei dati in arrivo, ne traggono insegnamenti, selezionano ciò che è più funzionale, e poi offrono all’uomo un compito finito o una decisione su come fare qualcosa o la previsione di qualcosa.

Per dare un esempio si consideri l’applicazione oggi più famosa di Machine Learning, che è la computer vision che sarà applicata ai mezzi di trasporto senza autista (Driverless). Il computer usa Machine Learning per dare un senso a oggetti e forme che si trova davanti e per svolgere un compito. Come detto sopra, il suo ‘occhio’ riceve dai tecnici immense quantità di dati su quegli oggetti e forme, impara a distinguerli usando i suoi algoritmi, e di conseguenza svolgerà poi il compito di guidare un’auto in mezzo a essi riconoscendoli e interpretandoli. Non fu facile per i ricercatori all’inizio: prendete un pedone. Prima che Machine Learning sapesse riconoscerlo ed evitarlo, dovette innanzi tutto imparare il concetto di dove inizia la sua forma e dove finisce, ci volle un lavoro computazionale incredibile. Eh sì, sembra assurdo, perché per noi l’idea di dove inizia e dove finisce una figura è scontata, ma non per un computer, che deve imparare anche quello fra miliardi di altre banalissime cose. Ma la velocità dei processori oggi è tale per cui i progressi di Machine Learning sono stati stupefacenti, ed è già in uso in una miriade di applicazioni industriali, aziendali e tecnologiche, la più importante delle quali è nella Medicina diagnostica. Grazie a Machine Learning, un computer sa ‘vedere’ milioni d’immagini nelle lastre, sa razionalizzarle, sa imparare cosa è cosa, e poi usa questo suo sapere su una determinata lastra per trovare ciò che l’occhio del medico potrebbe non aver visto.

Per dare un esempio si consideri l’applicazione oggi più famosa di Machine Learning, che è la computer vision che sarà applicata ai mezzi di trasporto senza autista (Driverless). Il computer usa Machine Learning per dare un senso a oggetti e forme che si trova davanti e per svolgere un compito. Come detto sopra, il suo ‘occhio’ riceve dai tecnici immense quantità di dati su quegli oggetti e forme, impara a distinguerli usando i suoi algoritmi, e di conseguenza svolgerà poi il compito di guidare un’auto in mezzo a essi riconoscendoli e interpretandoli. Non fu facile per i ricercatori all’inizio: prendete un pedone. Prima che Machine Learning sapesse riconoscerlo ed evitarlo, dovette innanzi tutto imparare il concetto di dove inizia la sua forma e dove finisce, ci volle un lavoro computazionale incredibile. Eh sì, sembra assurdo, perché per noi l’idea di dove inizia e dove finisce una figura è scontata, ma non per un computer, che deve imparare anche quello fra miliardi di altre banalissime cose. Ma la velocità dei processori oggi è tale per cui i progressi di Machine Learning sono stati stupefacenti, ed è già in uso in una miriade di applicazioni industriali, aziendali e tecnologiche, la più importante delle quali è nella Medicina diagnostica. Grazie a Machine Learning, un computer sa ‘vedere’ milioni d’immagini nelle lastre, sa razionalizzarle, sa imparare cosa è cosa, e poi usa questo suo sapere su una determinata lastra per trovare ciò che l’occhio del medico potrebbe non aver visto.

DEEP LEARNING & ARTIFICIAL NEURAL NETWORKS.

Sono i gemelli che sempre sentite nominare quando si parla di AI e di Machine Learning. Sono in pratica lo stesso concetto di Machine Learning ma ancor più sofisticato e molto più potente nel funzionamento. Partiamo dai secondi.

Come dice il nome, Artificial Neural Networks, essi sono la riproduzione (assolutamente rudimentale oggi) del sistema dei neuroni del cervello umano ma dentro un computer. In altre parole: non più i codici software, ma una simil-biologia umana per far funzionare le macchine ‘pensanti’. Anche qui l’idea ha circa 50 anni, ma solo di recente è decollata. I ricercatori fanno strati di neuroni artificiali – attenti: non sono micro cosine di plastica e rame, ma algoritmi – che si connettono fra di loro. Queste connessioni, sia chiaro, non sono neppure lontanamente ramificate e capaci come quelle biologiche, poiché sono costrette entro un ristretto numero di possibilità. Ora, per capire cosa succede in un Artificial Neural Network e a cosa serve, passiamo a un esempio diretto.

Il computer dovrà imparare a riconoscere all’istante un volto di un cliente e ciò che egli ha nel cestino delle compere, per abbinare sia il volto che le compere al suo conto corrente mentre se ne esce con la spesa da uno smart-shop, senza più passare per nessuna cassa né estrarre il portafoglio (gli smart-shop sono già realtà). Ecco come i tecnici di Machine Learning fanno sì che un Artificial Neural Networkimpari da solo a svolgere questo compito. Iniziamo dal riconoscimento del volto: l’immagine viene scomposta in blocchi che arrivano al primo strato di neuroni artificiali. Questi valutano emettendo un giudizio chiamato weighting (soppesare), poi il tutto passa al secondo strato che fa la stessa cosa, e così via fino alla fine, dove tutti i weighting messi assieme arrivano a una conclusione ‘pensata’. Cioè: la forma ovaleggiante dell’immagine (cranio-mascella); il fatto che ha due palle colorate parallele (occhi); che ha attorno qualcosa di colorato (capelli); ci sono altre cose bilaterali (narici, orecchie); si muove (muscoli facciali), ecc., tutto questo viene soppesato dai vari strati di Artificial Neural Networks e alla fine la macchina arriva a una conclusione: è un volto.

Dovete immaginare che questa ‘scuola’ viene ripetuta dal computer milioni di volte, e che esso è sottoposto a un bombardamento di milioni di dati tipici dei volti, fino ad arrivare a una velocità istantanea di riconoscimento di un volto. Un Artificial Neural Networkgià esperto in questo abbina poi quella faccia con precisione perché la trova all’istante fra tutti i volti precedentemente caricati, ad esempio, da una banca, e questo serve poi a completare il compito specifico che era appunto il riconoscimento per addebitare il conto corrente relativo. Vi basta ora replicare questa strepitosa capacità in mille altri campi operativi, industriali, sociali, infrastrutturali, per comprendere perché oggi Machine Learning e Artificial Neural Networks sono sulla bocca di tutti.

Se avete capito fin qui, e mi sono spellato il cervello per essere chiaro, allora è facile capire cosa significhi Deep Learning. Non è altro che l’amplificazione della tecnica sopra descritta negli Artificial Neural Networks su scala sempre maggiore e affidando ai computers algoritmi sempre più sofisticati. Fu l’idea dello scienziato Andrew Ng (Baidu), che comprese che per sveltire l’apprendimento delle macchine ‘intelligenti’ – ma soprattutto per permettere loro apprendimenti sempre più astratti, e quindi vicini a quelli del cervello umano – le si doveva dotare di Artificial Neural Networks giganti e le si doveva sottoporre a dosi colossali di dati. Fu proprio Andrew Ng che ingozzando un computer con 10 milioni di video permise al suo Artificial Neural Network di imparare per la prima volta a riconoscere un gatto. Replicare questo metodo per permettere alle macchine di imparare a ‘pensare’ sempre di più e quindi a svolgere compiti sempre più complessi, è di fatto il Deep Learning.

SARA’ DAPPERTUTTO. ADESSO LA CONOSCETE. GIOVANI, COSA FARE.

Ci sono due categorie d’italiani per cui quanto sopra è essenziale, ma in due modi radicalmente diversi: gli adulti e i giovani. Per gli adulti conoscere l’AI, e più in generale la travolgente rivoluzione globale delle nuove tecnologie chiamata Disruption, ha un valore politico imprescindibile. Per i giovani, cioè dai bambini ai ragazzi, si tratta di capire che chi rimane fuori almeno dalla comprensione di base dall’AI e dalla Disruption è oggi identico all’incolpevole italiano che negli anni ’50 non sapeva ancora leggere e scrivere, e mestamente da escluso sociale guardava le lezioni del Maestro Manzi a “Non è mai troppo tardi” alla RAI in bianco e nero, mentre tutti gli altri partecipavano al grande boom economico del dopoguerra con lavori, sicurezza sociale, e un futuro per i figli.

Per capire il valore politico dell’AI non ci vuole un genio. Queste tecnologie hanno un potere di analisi dei dati sconfinato. Oggi l’adesione a Internet di quasi tutti i cittadini, o anche solo il possesso di un cellulare, significa che coloro che gestiscono il digitale ci carpiscono lecitamente (quindi non Cambridge Analytica o la NSA) milioni di dati al giorno su: cosa facciamo o dove siamo, e quando; cosa diciamo o cosa leggiamo di politicamente rilevante; cosa compriamo, e quanto; lo scontento e il malumore sociale, di chi e dove; e moltissimo altro. Fino a pochissimo tempo fa quella mole cosmica di dati era usata dalle classi dirigenti, fa cui i politici, neppure all’1% perché non esisteva la tecnologia per analizzarli tutti e trarne conclusioni utili. Oggi invece l’AI di Machine Learning e del Data Mining ha spazzato via i sondaggisti come le calcolatrici spazzarono via il pallottoliere, e permette a classi dirigenti e politici un potere di predizione e quindi di manipolazione del consenso inimmaginabili. L’essenza stessa dei maggiori partiti esteri è cambiata: l’AI è il primo strumento di cui si sono dotati, e come sempre l’Italia li imiterà. Non capire oggi il nesso fra politica e AI è esattamente come chi negli anni ‘50 si fosse rifiutato di capire il nesso fra l’arrivo della Tv e la politica.

Nell’economia nazionale, che sono i nostri lavori, redditi, pensioni, alloggi, salute, l’arrivo dell’AI significa una cosa semplice: amplificare il potere di tutto. Questo perché qualsiasi sviluppo dirompente che oggi si applica nell’istruzione, nell’agricoltura, nella finanza, nella sanità, nei trasporti, nelle infrastrutture, nell’industria, nell’azienda, sarebbe rimasto uno scatolone vuoto senza una tecnologia che ne sapesse analizzare e capire la cosmica quantità di nuovi dati, per poi suggerire innovazioni. L’AI esiste proprio per questo, e cambierà tutto.

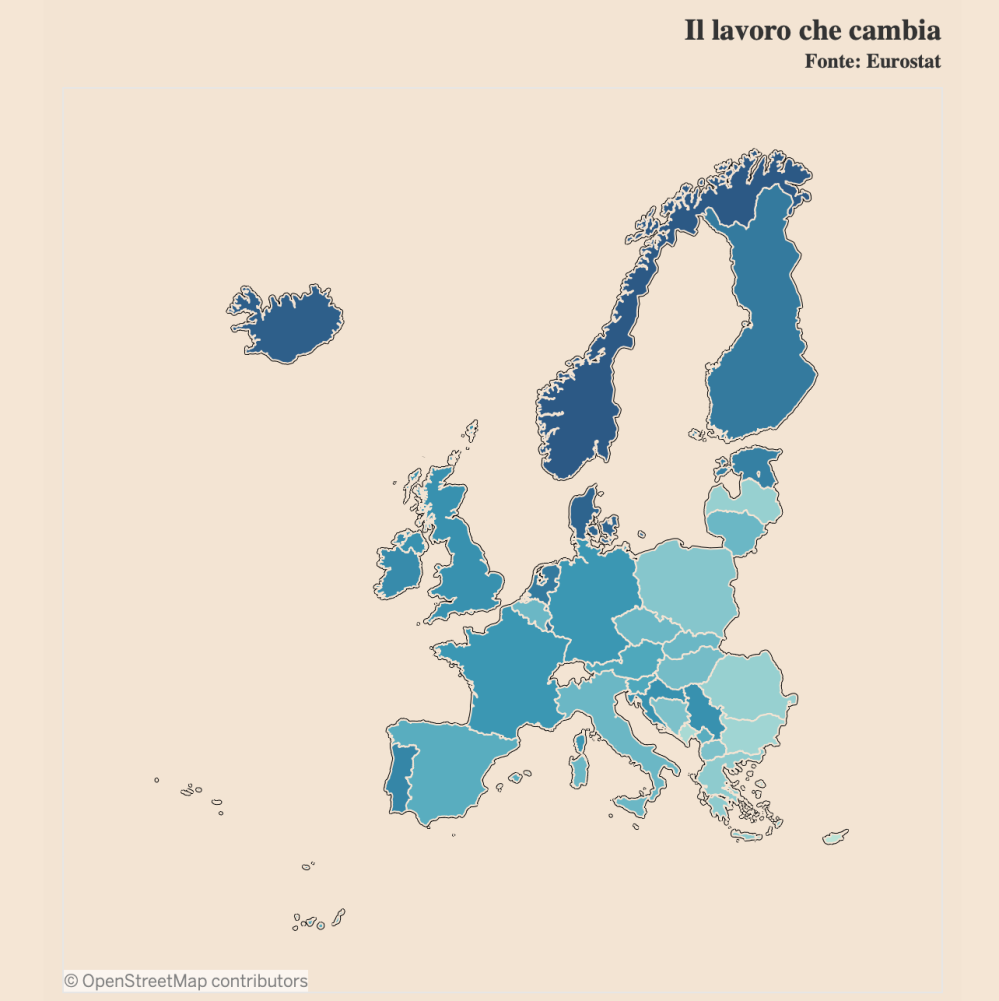

Per i vostri figli piccoli, e per i ragazzi, posso solo ripetere ciò che ho già scritto tante volte. L’AI e la Disruption delle nuove tecnologie sta, in queste ore, ridipingendo il mondo del lavoro come mai nella storia umana. Ne ho già trattato lungamente. Uno può scalciare, può illudersi, e negare la realtà, faccia pure, sarà solo un perdente, come il povero italiano analfabeta che vagava le strade del boom economico del dopoguerra. Seguite il mio consiglio: leggete i pochissimi autori come me che vi stanno raccontando ‘live’, giorno dopo giorno, cosa succede a Disruption & Work e quali capacità (gli Skills) è oggi prioritario acquisire nell’era della Disruption. Ma, genitori dei piccoli e ragazzi adolescenti, io mi spingo ancora oltre: leggeteci, e poi confrontatevi con gli insegnanti, e se li troverete scettici o addirittura impreparati su questi temi fate manifestazioni per pretendere che vi tutelino con gli aggiornamenti, in particolare, ripeto, su Disruption & Work. Perché quando uno dei Signori del mondo di oggi, Google-Alphabet, scrive sulla home la frase che conclude questo paragrafo, un giovane deve schizzare sulla sedia come la dinamite se davvero sogna un lavoro dignitoso, una vita da persona libera: “Il 65% degli studenti di oggi lavoreranno in lavori che neppure ancora esistono”.

Ora sapete tutti almeno le basi, solide e informate, su cosa sai l’Artificial Intelligence, e perché non conoscerla non è più un optional. Ora fate la vostra parte e divulgate questo articolo.

(le immagini sono dei rispettivi proprietari)

Per dare un esempio si consideri l’applicazione oggi più famosa di Machine Learning, che è la computer vision che sarà applicata ai mezzi di trasporto senza autista (Driverless). Il computer usa Machine Learning per dare un senso a oggetti e forme che si trova davanti e per svolgere un compito. Come detto sopra, il suo ‘occhio’ riceve dai tecnici immense quantità di dati su quegli oggetti e forme, impara a distinguerli usando i suoi algoritmi, e di conseguenza svolgerà poi il compito di guidare un’auto in mezzo a essi riconoscendoli e interpretandoli. Non fu facile per i ricercatori all’inizio: prendete un pedone. Prima che Machine Learning sapesse riconoscerlo ed evitarlo, dovette innanzi tutto imparare il concetto di dove inizia la sua forma e dove finisce, ci volle un lavoro computazionale incredibile. Eh sì, sembra assurdo, perché per noi l’idea di dove inizia e dove finisce una figura è scontata, ma non per un computer, che deve imparare anche quello fra miliardi di altre banalissime cose. Ma la velocità dei processori oggi è tale per cui i progressi di Machine Learning sono stati stupefacenti, ed è già in uso in una miriade di applicazioni industriali, aziendali e tecnologiche, la più importante delle quali è nella Medicina diagnostica. Grazie a Machine Learning, un computer sa ‘vedere’ milioni d’immagini nelle lastre, sa razionalizzarle, sa imparare cosa è cosa, e poi usa questo suo sapere su una determinata lastra per trovare ciò che l’occhio del medico potrebbe non aver visto.

Per dare un esempio si consideri l’applicazione oggi più famosa di Machine Learning, che è la computer vision che sarà applicata ai mezzi di trasporto senza autista (Driverless). Il computer usa Machine Learning per dare un senso a oggetti e forme che si trova davanti e per svolgere un compito. Come detto sopra, il suo ‘occhio’ riceve dai tecnici immense quantità di dati su quegli oggetti e forme, impara a distinguerli usando i suoi algoritmi, e di conseguenza svolgerà poi il compito di guidare un’auto in mezzo a essi riconoscendoli e interpretandoli. Non fu facile per i ricercatori all’inizio: prendete un pedone. Prima che Machine Learning sapesse riconoscerlo ed evitarlo, dovette innanzi tutto imparare il concetto di dove inizia la sua forma e dove finisce, ci volle un lavoro computazionale incredibile. Eh sì, sembra assurdo, perché per noi l’idea di dove inizia e dove finisce una figura è scontata, ma non per un computer, che deve imparare anche quello fra miliardi di altre banalissime cose. Ma la velocità dei processori oggi è tale per cui i progressi di Machine Learning sono stati stupefacenti, ed è già in uso in una miriade di applicazioni industriali, aziendali e tecnologiche, la più importante delle quali è nella Medicina diagnostica. Grazie a Machine Learning, un computer sa ‘vedere’ milioni d’immagini nelle lastre, sa razionalizzarle, sa imparare cosa è cosa, e poi usa questo suo sapere su una determinata lastra per trovare ciò che l’occhio del medico potrebbe non aver visto.